Nhiều ứng dụng trong xử lý ngôn ngữ tự nhiên hiện nay dựa vào việc điều chỉnh một mô hình ngôn ngữ (Fine-tuning) đã được đào tạo trước (Pretrained) cho các tác vụ cụ thể (Còn được gọi là fine-tuning). Một điểm yếu lớn của việc điều chỉnh là mô hình mới chứa số tham số tương đương với mô hình gốc. Vì vậy, nếu mô hình được đào tạo trước có kích thước lớn (ví dụ 175 tỷ tham số), việc lưu trữ và triển khai mô hình đã được chỉnh sửa có thể gặp khó khăn.

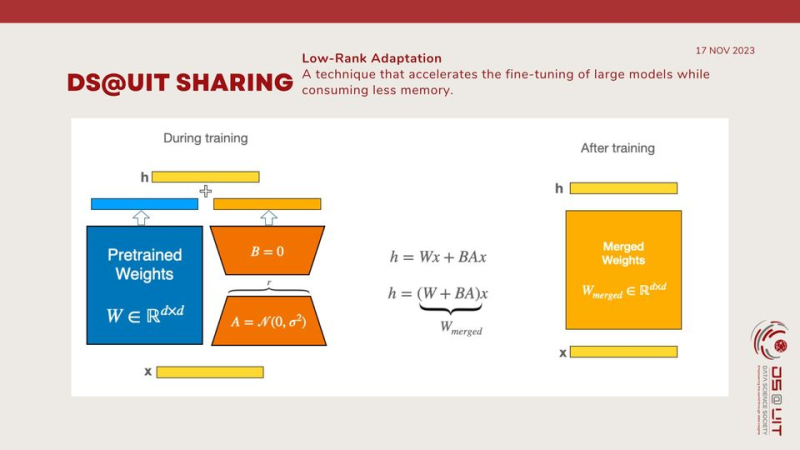

Một trong những giải pháp cho vấn đề này là LoRA (low-Rank Adaptation) - một kỹ thuật giúp tăng tốc quá trình điều chỉnh các mô hình lớn trong khi tiêu tốn ít bộ nhớ hơn.

Để làm cho việc điều chỉnh hiệu quả hơn, phương pháp của LoRA là biểu diễn các cập nhật trọng số bằng hai ma trận nhỏ hơn (gọi là ma trận cập nhật) thông qua phân rã ma trận rank thấp (low-rank decomposition). Các ma trận mới này có thể được huấn luyện để thích nghi với dữ liệu mới trong khi giữ khối lượng tham số cập nhật thấp. Ma trận trọng số ban đầu vẫn được đóng băng và không nhận bất kỳ điều chỉnh nào. Để tạo ra kết quả cuối cùng, cả trọng số ban đầu và trọng số đã được điều chỉnh được kết hợp.

Cách tiếp cận này có một số ưu điểm chính:

LoRA giúp cho việc điều chỉnh mô hình hiệu quả hơn bằng cách giảm đáng kể số lượng tham số có thể huấn luyện.

Trọng số của mô hình được đào tạo trước được giữ đóng băng, điều này có nghĩa là bạn có thể có nhiều mô hình LoRA nhẹ phục vụ cho các nhiệm vụ cụ thể được xây dựng trên mô hình cơ sở của chúng.

LoRA độc lập với nhiều phương pháp điều chỉnh hiệu quả tham số khác và có thể kết hợp với nhiều phương pháp đó.

Hiệu suất của các mô hình điều chỉnh bằng LoRA có thể sánh ngang với hiệu suất của các mô hình được điều chỉnh theo cách truyền thống.

LoRA không tạo thêm bất kỳ độ trễ khi đưa ra kết quả vì trọng số adapter có thể được hợp nhất với mô hình cơ sở.

Số lượng tham số có thể huấn luyện trong một mô hình LoRA phụ thuộc vào kích thước của các ma trận cập nhật low-rank, chủ yếu được xác định bởi rank và hình dạng của ma trận trọng số ban đầu.

Tóm lại, việc điều chỉnh các mô hình ngôn ngữ lớn là cực kỳ tốn kém về phần cứng. LoRA, một chiến lược thích nghi hiệu quả không chỉ không tạo độ trễ đưa ra kết quả mà vẫn duy trì chất lượng mô hình lớn, cho phép chuyển đổi nhanh chóng giữa các tác vụ khi triển khai dưới dạng dịch vụ bằng cách chia sẻ hầu hết các tham số của mô hình.

Mọi thông tin chi tiết xem tại: https://www.facebook.com/dsociety.uit.ise/posts/pfbid0TUKH4aeEg2PQ4otb3FsHYfnkjMRMUzDtXrX5Bw2GU5dErT8Hdey95QgsU58me2cnl

Hạ Băng - Cộng tác viên Truyền thông trường Đại học Công nghệ Thông tin

![[SEAPP 2025] - Tham dự triển lãm và bình chọn sản phẩm yêu thích [SEAPP 2025] - Tham dự triển lãm và bình chọn sản phẩm yêu thích](https://www.uit.edu.vn/sites/vi/files/styles/uit_thumb/public/uploads/images/thumbs/202512/598948406_1452015606930680_4138193739191835155_n.jpg?itok=izDUegz4)