Tự học tăng cường với Phản hồi từ Con Người (RLHF) đại diện cho một bước tiến quan trọng trong lĩnh vực học máy, kết hợp sức mạnh của trí tuệ nhân tạo với kiến thức của con người. Trong RLHF, ý tưởng cốt lõi là cho một tác tử học bằng cách tương tác với môi trường và đồng thời nhận thông tin phản hồi xây dựng từ người hướng dẫn. Phương pháp kết hợp này nối nghiệp giữa quá trình ra quyết định tự động và khả năng kiến thức của con người, tạo ra một tương tác tăng cường làm phong phú quá trình học hỏi.

Các yếu tố Quan trọng của RLHF

1. Tác Tử (Agent): Đây là thực thể đang được đào tạo, có thể là hệ thống trí tuệ nhân tạo, robot, hoặc bất kỳ người ra quyết định tự động nào. Tác tử đóng vai trò quan trọng trong RLHF và phải học từ cả phần thưởng từ môi trường lẫn những thông tin quý báu từ người hướng dẫn.

2. Hành Động (Action): Hành động là các quyết định do tác tử thực hiện để tương tác và điều hướng trong môi trường. Các hành động của tác tử được ảnh hưởng bởi kinh nghiệm trước đó, dấu vết của môi trường và phản hồi từ con người.

3. Môi Trường (Environment): Môi trường đại diện cho ngữ cảnh hoặc hệ thống mà tác tử hoạt động. Nó có thể là không gian vật lý, thế giới ảo hoặc bất kỳ hệ thống phức tạp nào mà cần phải ra quyết định.

4. Phần Thưởng và Phản Hồi từ Con Người: Một trong những đặc điểm nổi bật của RLHFlà việc kết hợp phản hồi từ con người. Trong khi học tăng cường truyền thống dựa hoàn toàn vào phần thưởng từ môi trường, RLHF giới thiệu phản hồi đánh giá từ con người. Phản hồi này có thể ở dạng hướng dẫn của chuyên gia, sự ưu tiên của con người hoặc quan sát trực tiếp. Phản hồi từ con người làm phong phú quá trình học hỏi bằng cách cung cấp hướng dẫn sâu hơn và ngữ cảnh thực tế.

5. Chiến Lược (Strategy): Chiến lược, hoặc chuỗi hành động, là kết quả cuối cùng của RLHF. Nó bao gồm quyết định của tác tử, tích hợp cả việc dựa trên môi trường và dựa trên phản hồi từ con người. Mục tiêu là tạo ra một chiến lược tối đa hóa phần thưởng và tuân theo các mục tiêu và kiến thức của con người.

Ứng Dụng của RLHF:

RLHF được áp dụng trong nhiều lĩnh vực khác nhau, nơi kiến thức của con người là quan trọng. Dưới đây là một số ví dụ:

- Robotics (Robot học): Robot có thể học các nhiệm vụ phức tạp với sự hướng dẫn của con người, giúp chúng trở nên mạnh mẽ và an toàn hơn trong các tình huống thực tế.

- Phương Tiện Tự Động: RLHF có thể giúp xe tự lái điều hướng các tình huống phức tạp bằng cách kết hợp hướng dẫn từ con người để cải thiện quyết định ra quyết định.

- Trợ lý ảo: Các chatbot và trợ lý ảo có thể cung cấp câu trả lời cụ thể và chính xác hơn bằng cách sử dụng phản hồi từ con người để cải thiện khả năng hiểu ngôn ngữ tự nhiên và chất lượng cuộc trò chuyện.

- Chăm sóc sức khỏe: Trong chẩn đoán bệnh và đề xuất điều trị y tế, RLHF có thể kết hợp kiến thức và sự chuyên môn của các chuyên gia y tế để cải thiện việc chăm sóc bệnh nhân.

- Chơi trò chơi: RLHF có thể được sử dụng để tạo ra các tác tử chơi trò chơi học từ cả phần thưởng của trò chơi và từ các game thủ chuyên nghiệp, dẫn đến những trải nghiệm chơi game thú vị và đầy thách thức hơn.

Tóm lại, Học tăng cường với Phản hồi từ Con Người là một mô hình mạnh mẽ kết hợp sức mạnh của cả máy móc và con người. Bằng cách kết hợp trí tuệ nhân tạo với kiến thức của con người, RLHF tạo ra các hệ thống thông minh có khả năng thích nghi, có khả năng điều hướng trong các môi trường phức tạp và động, đồng thời ra quyết định thông thái tuân thủ với mục tiêu và kiến thức của con người. Phương pháp này có tiềm năng làm cuộc cách mạng trong nhiều ứng dụng và ngành công nghiệp khác nhau bằng cách cải thiện khả năng học và ra quyết định của các hệ thống trí tuệ nhân tạo.

-----------------------------------------------------------------------------------

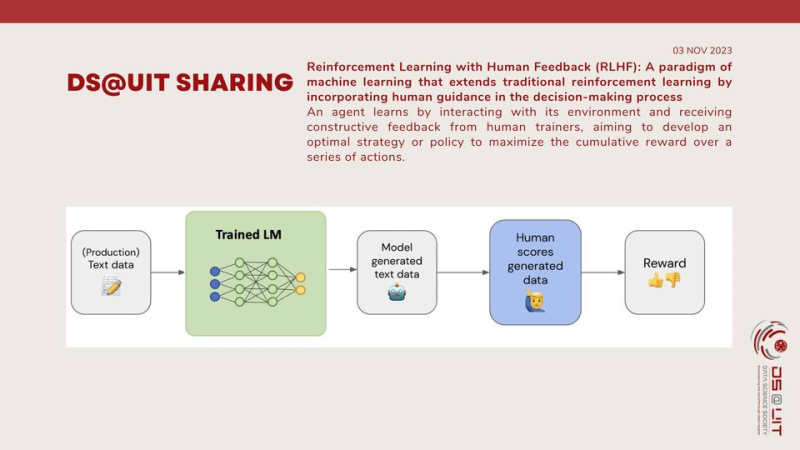

Reinforcement Learning with Human Feedback (RLHF) represents a significant advancement in the realm of machine learning, blending the power of artificial intelligence with human expertise. In RLHF, the core idea is for an agent to learn by interacting with an environment while also receiving constructive input from human trainers. This hybrid approach bridges the gap between automated decision-making and human wisdom, creating a synergy that enhances the learning process.

Key Components of RLHF:

1. Agent: This is the entity under training, whether it's an AI-driven system, a robot, or any autonomous decision-maker. The agent is at the heart of RLHF and is responsible for learning from both the environment's rewards and the valuable insights provided by human trainers.

2. Action: Actions are the choices made by the agent to navigate and interact with its environment. The agent's actions are influenced by its past experiences, environmental cues, and human feedback.

3. Environment: The environment signifies the context or system in which the agent operates. It could be a physical space, a virtual world, or any complex system where decisions need to be made.

4. Reward and Human Feedback: One of the distinguishing features of RLHF is the inclusion of human feedback. While traditional reinforcement learning relies solely on environmental rewards, RLHF introduces human evaluative feedback. This feedback can be in the form of expert guidance, preference rankings, or direct observations. Human feedback enriches the learning process by providing nuanced guidance and real-world context.

5. Strategy: The strategy, or the sequence of actions, is the ultimate output of RLHF. It encapsulates the agent's decisions, incorporating both environment-based and human feedback-based learning. The goal is to create a strategy that maximizes rewards and aligns with human-defined objectives.

Applications of RLHF:

RLHF finds applications in various domains, where human expertise is invaluable. Here are some examples:

- Robotics: Robots can learn complex tasks with human guidance, making them more adaptable and safer in real-world scenarios.

- Autonomous Vehicles: RLHF can help self-driving cars navigate challenging situations by incorporating human guidance to improve decision-making.

- Virtual Assistants: Chatbots and virtual assistants can provide more relevant and accurate responses by leveraging human feedback to improve their natural language understanding and conversation quality.

- Healthcare: In medical diagnostics and treatment recommendations, RLHF can incorporate the knowledge and expertise of healthcare professionals to enhance patient care.

- Game Playing: RLHF can be used to create game agents that learn not just from game rewards but also from expert gamers, leading to more engaging and challenging gaming experiences.

In summary, Reinforcement Learning with Human Feedback is a powerful paradigm that leverages the strengths of both machines and humans. By fusing artificial intelligence with human wisdom, RLHF creates adaptable, intelligent systems capable of navigating complex, dynamic environments and making informed decisions that align with human goals and expertise. This approach holds the potential to revolutionize a wide range of applications and industries by enhancing the learning and decision-making capabilities of AI systems.

Mọi thông tin chi tiết xem tại: https://www.facebook.com/dsociety.uit.ise/posts/pfbid02iVoTNEpHKchcZL5PtGuAKZuRwxTmk6u1uECuSVesAgZkKk6TepxQi8WXEswRWNval

Hạ Băng - Cộng tác viên Truyền thông trường Đại học Công nghệ Thông tin